El origen de la vida (Clair Edwin Folsome)

No muchos libros brindan una visión general de cuáles fueron las posibles vías de evolución. Este libro narra la historia de la vida en la tierra, desde la composición del universo y la formación de la tierra hasta la aparición de los primeros organismos vivientes. A continuación, resumiremos de manera concisa cada uno de los capítulos de este importante y clásico libro.

Capítulo 1 – La química del universo

El universo tiene un origen común que puede ser rastreado en el tiempo. Toda la materia de la que está compuesta el universo deriva de los productos de las reacciones nucleares del hidrógeno.

El hombre en su afán de investigación trata de comprender todo fenómeno de la naturaleza, muchas veces lo hace con una meta específica, es decir, con una finalidad, pero otras solo lo hace por pura curiosidad. Determinar la composición de una estrella posible es fundamental para el estudio de los cuerpos celestes, conocer la composición de una estrella nos puede servir desde para determinar la edad de la estrella hasta analizar si el planeta es apto o no para la vida.

Para hallar la identidad de los elementos que componente una estrella se analiza su espectro de emisión en una placa fotográfica. Es posible observar un espectro de emisión de una sustancia al energizar una muestra de material de energía térmica. Así, una barra de hierro calentada al rojo vivo recién sacada de la fuente emite un resplandor característico que no posee ningún otro elemento. Este mismo fenómeno es aplicado para el estudio de la naturaleza de los astros; ya que los gases en él ya se encuentran energizados basta capturar un haz de la luz emitida por él, analizarlo mediante la separación de cada uno de ellos por un prisma de modo que los rayos separados incidan en una placa fotográfica dejando su huella “digital” en él. Decimos huella digital porque cada elemento químico posee un espectro de emisión único que no encuentra parangón con algún otro elemento de modo que si conocemos el espectro de emisión de una sustancia de composición desconocida al analizar el espectro de emisión de la sustancia podremos determinar qué elementos están comprendidos en dicha sustancia.

Otra manera de averiguar identidad de un gas es colocar una fuente luminosa detrás de la muestra y analizar el espectro de absorción del gas en una placa fotográfica, este es complementario al espectro de emisión en todos los casos.

Todos los cuerpos celestes tienen básicamente la misma composición química (H, He, Li, etc.) porque estos elementos son los que se forman con mayor frecuencia en una reacción de fusión nuclear, más bien, son los que se forman más fácil. Los elementos más pesados también están presentes pero debido a la dificultad de formarlos la frecuencia con la que los podríamos encontrar es muy baja.

Los científicos desde hace muchos años se han preguntado si el universo tenía las características que posee ahora desde su origen o si por el contrario va cambiando con el tiempo. El efecto Doppler nos puede ayudar con este problema.

El efecto Doppler se deduce a partir de la observación experimental de que un mismo sonido (onda) dependiendo de la velocidad que tenga el cuerpo que lo produce y de su dirección va a tener una longitud de onda distinta. El caso más familiar es el de la sirena de una ambulancia que mientras se acerca se va haciendo más agudo, pero cuando se aleja se va haciendo más grave. Otro caso similar es el de dos carros de policía en marcha situados uno detrás del otro. Si nos encontramos entre ambos coches escucharemos dos sonidos diferentes, pero en cuanto los autos se detengan el sonido de ambos se uniformizará a uno diferente al de ambos.

En el caso del espectro visible de la radiación electromagnética, si el objeto se aleja, su luz se desplaza a longitudes de onda más largas, produciéndose un corrimiento hacia el rojo. Si el objeto se acerca, su luz presenta una longitud de onda más corta, desplazándose hacia el azul. Esta desviación hacia el rojo o el azul es muy leve incluso para velocidades elevadas, como las velocidades relativas entre estrellas o entre galaxias, y el ojo humano no puede captarlo, solamente medirlo indirectamente utilizando instrumentos de precisión como espectrómetros.

De esta manera al analizar un número determinado de astros determinamos que el universo se encuentra en expansión. Este fundamento físico convierte en irrefutable a esta postura.

La fusión de hidrógeno en helio es la principal fuente de energía de los astros, esta fusión no es completamente conservativa ya que una parte de la masa se pierde en forma de energía. Dicha energía toma la forma de energía térmica y energía radiante, principalmente.

La edad del universo puede calcularse mediante el conocimiento de la abundancia de los elementos y las velocidades de las reacciones nucleares de las estrellas, esta oscila entre 10 000 y 13 000 millones de años.

Capítulo 2 – Edad de las estrellas y de los planetas

El equilibrio interno de una estrella cambia a medida que envejece y se va produciendo la fusión del hidrógeno, debido a esto los intentos iniciales de cálculo de la edad de las estrellas resultaron errados.

Las fuerzas gravitacionales hacia el núcleo son contrarrestadas por las fuerzas hidrostáticas que tienden hacia la expansión; si la temperatura disminuye también disminuyen las fuerzas de expansión y la estrella se contrae, si aumenta la temperatura se produce el efecto contrario y la estrella se expande.

Las grandes estrellas poseen más masa, masa que contiene átomos de hidrógeno que pueden fusionarse y dar lugar a átomos de helio. Como cada fusión nuclear libera cierta cantidad de energía a mayor número de fusiones mayor cantidad de energía de la estrella, esta energía puede estar expresada como energía térmica. Pero una temperatura elevada induce la fusión de los átomos de hidrógeno, es decir, a mayor temperatura mayor velocidad de fusión y como la temperatura depende de la masa: a mayor masa mayor velocidad de fusión que no es nada más que el consumo de hidrógeno. En consecuencia, las estrellas grandes son más calientes y tiene un tiempo de vida menor que las pequeñas.

Cuando cualquier estrella ha consumido el 10% de su hidrógeno inicia su temperatura disminuye y se produce una expansión.

El color de cada estrella es indicativo de su temperatura: el azul corresponde a las estrellas muy calientes, el blanco a las calientes y el rojo a las estrellas relativamente frías.

La siguiente imagen es una gráfica que muestra la relación entre el color de la estrella y la magnitud de la estrella; recibe el nombre de diagrama de Hertzsprung-Russell e incluye estrellas de todo tamaño y edad.

La mayor parte de las estrellas están situadas en la parte recta del diagrama (secuencia principal), son las que están fusionando su hidrógeno con solo ligeros cambios de equilibrio.

Considerando todos estos factores podemos determinar la edad de una estrella; se han analizado numerosas estrellas y ninguna de ella supera los 11000 millones de años, por lo que podemos conjeturar que posiblemente esta sea la edad media del universo.

Con aceleraciones similares, las partículas más pesadas adquieren velocidades inferiores que las partículas más ligeras; como consecuencia de ello los isótopos más ligeros participan con mayor facilidad en las reacciones químicas rápidas que discurren en un solo sentido. Con lo que una mayor proporción de los compuestos tendrá a los isotopos más livianos de los átomos.

Los mecanismos de descomposición de radio isotopos son los siguientes: emisión alfa, emisión beta y captura electrónica.

Capítulo 3 – Formación del sistema planetario

Nuestro sistema planetario se formó a partir de una nebulosa, esta pasó por diversos cambios gravitacionales que ocasionaron el aumento en la densidad (compresión) de la nebulosa, luego de esto se fracciono constamente hasta alcanzar una masa apropiada.

Una vez formada esta fracción las partículas comenzaban a atraerse por magnetismo, fuerzas electrostáticas, gravedad, etc. una vez formada la protoestrella esta comenzaba a eliminar parte de su masa en erupciones y ráfagas que arrojaban materiales al espacio. Estos materiales, por efecto de la gravedad comienzan a orbitar a la protoestrella y poco a poco comienza a aglomerarse y formar planetas que orbitan esta protoestrella.

Los planetas que orbitan una estrella se clasifican en tres tipos, según la distancia a la estrella, terrestres (internos) y gaseosos (externos). En el caso particular del sistema solar el cinturón de asteroides delimita estos dos espacios.

Los planetas terrestres poseen una mayor temperatura, como consecuencia de esto el vulcanismo constante expulsa la mayoría de gases volátiles nuevamente hacia el espacio. Es por eso que los elementos que son tan comunes en el universo son raros en los planetas terrestres. Los planetas de la zona externa son fríos, esta temperatura ocasiona la presenten, en forma de cristales, de elementos volátiles.

Capítulo 4 – Origen y evolución de la atmósfera terrestre

Los planetas de tipo terrestre han sido formados principalmente por agregados no volátiles refractarios; entre ellos, el hidrógeno, sin embargo, este no es el más abundante, ¿por qué?

Se puede dividir la vida de la tierra en dos periodos el de vulcanismo primario (4500 – 4000 millones) y vulcanismo hawaiano.

El vulcanismo primario tuvo lugar en una tierra que carecía de núcleo definido, el interior del planeta se encontraba bajo constantes reordenamientos de la materia constituyente. Durante este estadio la mayor cantidad de hierro metálico se encontraba mezclado en toda la extensión de la tierra.

Se han estimado las concentraciones de los diversos gases de esta época y se ha llegado a la conclusión de que el metano era una especie sumamente rara y que el nitrógeno y vapor de agua representaban el grueso de gases.

Los gases volcánicos representaban la principal fuente de gases para la atmósfera y de ellos dependía en gran medida la composición de tal.

Composición de los gases volcánicos de la atmósfera primitiva de la Tierra

A diferencia del estado actual de la atmósfera, la atmósfera primitiva carecía de una capa de ozono definida debido a que la concentración de oxígeno era muy baja en ese periodo. Debido a esto, los rayos ultravioletas incidían directamente sobre la Tierra sobre una superficie casi desnuda. Los rayos ultravioletas representaron la principal fuente energética de la Tierra primitiva seguida de las descargas eléctricas, la radioactividad, el calor volcánico y por último los impactos meteóricos.

Hace 4000 millones de años el interior semifundido de la Tierra sufrió una importante reorganización. El hierro metálico y el níquel, que ante5riromente habían estado mezclados con otros minerales en el manto superior, se reforman y pasa a forman un núcleo de hierro y níquel fundido sobre el cual yace un nuevo manto y corteza.

Este estado en el que ya se encuentra un núcleo bien estructurado recibe el nombre de era volcánica hawaiana.

En la era hawaiana el agua era 100 veces más abundante que el hidrógeno, 40 más abúndate que el CO, el nitrógeno se emitía en forma casi incesante y el metano aún se encontraba en concentraciones casi nulas.

De los gases dominantes el agua se condensa en forma de lluvia, la mayor parte del CO2 se disuelve en los océanos que se forman rápidamente y el nitrógeno se acumula en la atmosfera.

Este estadio de evolución de la atmosfera empezó hace unos 4 000 millones de años y duro 1500 2000 millones de años; terminó cuando empezó la síntesis biológica de O2 que era la única diferencia entre la atmósfera actual y la atmósfera de la era hawaiana.

Capítulo 5 – La evolución química

Hace 4500 millones de años las condiciones terrestres experimentaron un notable cambio, de modo que propiciaron la formación de nuevos gases por la reacción de algunos ya existentes.

Visto sin mayor detenimiento, las concentraciones de metano y amoniaco deberían haber sido mayores en este periodo inicial; sin embargo, esto no sucede por el hecho de que existen otros elementos que reaccionan con los precursores del metano y amoniaco; por ello, cuando analizamos material de este periodo no encontramos las concentraciones que ingenuamente calculamos en base a las emisiones volcánicas y demás.

Con una atmósfera más consolidada es posible que se den múltiples reacciones que forman, a su vez, un número considerable de nuevos compuestos, entre ellos destacan los compuestos alquitranados que, según se piensa, son los precursores para la vida.

Para comprender como se formó la vida debemos conocer la composición de los gases de la atmósfera de la época; para esto se llevaron a cabo numerosos experimentos; entre los más destacados experimentos se encuentran el de Urey y Miller, el de Edward Ander y el de Calvin. Todos los científicos citados reproducen un aspecto de las condiciones ambientales de la época. A continuación, se expondrán brevemente sus postulados.

Urey y Miller se concentraron en la energía proporcionada por las tormentas eléctricas. Su experimento consistía en colocar una serie de gases, como amoniaco y metano, en un recipiente herméticamente sellado que junto con una caldera de agua hirviendo simulaban las condiciones atmosféricas reinantes en esa época. Al energizar estos gases reaccionan entre sí dando lugar a compuestos orgánicos.

A partir de este experimento se han desarrollado una serie de variantes que confirman que la generación de compuestos orgánicos esenciales para la vida no requiere de un organismo vivo como se creía sino solo de ciertas condiciones energéticas y atmosféricas.

Productos orgánicos encontrados luego de la descarga eléctrica sobre una mezcla de NH4, NH3, y H2 (las concentraciones son relativas al ácido fórmico)

Edward Ander y su equipo se focalizaron en la energía calorífica proporcionada por los volcanes. Su experimento consistía en calentar una muestra de gases, en un recipiente sellado, en presencia de catalizadores inorgánicos. El resultado del análisis de los gases luego del proceso calórico apuntaba, nuevamente, a que la creación de compuestos orgánicos y polímeros a partir de compuestos inorgánicos era independiente de la vida.

Productos orgánicos encontrados luego de la síntesis térmica. Los gases como CO2, NH3, y H2 son calentados a 900°C y acompañados de catalizadores inorgánicos.

Bar-Nun ha demostrado que ondas de choque similares a las producidas por caída de meteoritos pueden interaccionan con los componentes gaseoso de la atmósfera primitiva dado lugar a la formación de aminoácidos y de productos intermedios reactivos.

Melvin Calvin expuso una mezcla de amoniaco, metano y agua a una fuente radioactiva. El resultado indicaba la presencia de compuestos vinculados con la vida.

Todos estos experimentos y otros más indican que la evolución química fue un hecho innegable.

Capítulo 6 – Una definición de vida

Ahora nos corresponde una labor igual de ardua: definir la vida.

Muchos científicos esquivaron el verdadero problema de definir que es la vida y, en vez de eso, comenzaron a nombrar una serie de características de lo que ellos consideraban como vida. Pasaban los años y se iban encontrando cada vez más excepciones para esta serie de características por lo que este intento de definición resultaba inadmisible.

La definición más lograda debe tratar temas como los son: la fuente de energía, el medio para la vida, los componentes básicos de la vida y su interrelación, etc. Esta definición nos la brindan Onsager y Morowitz:

“Vida es la propiedad de la materia que resulta del acoplamiento de los ciclos de los bioelementos en solución acuosa, activados fundamentalmente por la energía radiante en orden a alcanzar la máxima complejidad”

A continuación, explicaremos cada punto de esta definición.

Cuatro elementos componen la mayor parte de la materia viva en la tierra, estos son el carbono, el hidrógeno, el oxígeno, el nitrógeno, el fósforo y el azufre. Estos seis elementos son conocidos como bioelementos y desempeñan roles muy importantes en el mantenimiento de la vida. Cada uno de estos bioelementos posee un ciclo, en un organismo vivo estos ciclos se acoplan, es decir, se interrelacionan dado lugar al entramado bioquímico que sostiene la vida.

Todas las reacciones que se dan en un organismo vivo dependen del agua, es decir, para que las reacciones procedan requieren de un medio acuoso.

Como ya habíamos explicado, la principal fuente de energía que tiene el planeta es la radiante del sol, esto también se cumple en los seres vivos. Es la energía radiante la que brinda el empuje inicial a los ciclos biológicos; aunque pensemos que algunos ciclos están desligados de la energía radiante lo que sucede es que no estamos observando el cuadro completo, ya que si todos los ciclos están interrelacionados y la mayoría de ellos depende de la energía radiante podemos decir que los ciclos como conjunto depende de la energía radiante del Sol.

La selección natural orienta el desarrollo de toda criatura viva. Analizando muchos casos notamos que en la mayoría de ellos pareciera que cada vez que la especie se va desarrollando su complejidad va aumentando.

Esta definición satisface todos los puntos citados y, además, expone una realidad: los organismos vivos pareciera que están encaminados a complejizarse cada vez más.

Capítulo 7 – Los protobiontes

Ahora analizaremos el camino que tuvo que recorrer el conjunto de compuestos orgánicos para convertirse en un ser vivo.

Entre lo químico y lo biológico se hallan los protobiontes, estos presentan, de manera incipiente, algunas características que se utilizaron para describir la vida. El origen de esa forma primitiva de vida es debatible y un tema de controversia. A continuación, se exponen las principales teorías desarrolladas por los investigadores mejor entendidos.

Oparin propone la existencia de un coacervado que poco a poco desarrollaba una genética y un metabolismo. El principal problema de su postulado es lo fantástico que resultan las condiciones de formación de los coacervados (elevada concentración, pH estable, etc.).

Coacervados:

Otro de los científicos que desarrollaron este tema fue Sidney Fox. Su experimento consistía en calentar una mezcla de aminoácidos secos y sumergirlos en agua, al hacer esto podían aislarse de la mezcla unos polímeros llamados protenoides. Los protenoides son moléculas parecidas a las proteínas sintetizadas formadas al azar. Cuando se enfrían, las disoluciones de protenoides forman unas esferas parecidas a células ancestrales.

Microesferas de protenoides:

Nuevamente este postulado requiere de condiciones muy específica que lo convierten en improbable de ocurrir en la naturaleza.

J.D. Benal propuso una solución al problema de la concentración; esta era una especie de arcilla que se unía a compuestos orgánicos y que al precipitar aumentaba la concertación de biomoléculas en ese sector. Esta teoría es rebatida ya que estas arcillas expondrían de sobremanera a las biomoléculas formadas a la energía de los rayos ultravioleta, estos las destruirían.

Actualmente se presenta como posibilidad, y casi un hecho, la formación de protobiontes a partir de los lípidos que se encontraban flotando en el mar y que al formar esferas precipitaban al fondo marino, lo que los salvaba de la radiación ultravioleta.

Los microfósiles son la evidencia de que la vida surgió hace 300 millones de años, los estromatolitos son un tipo de microfósiles que resultan de la aglutinación de microalgas.

Estromatolitos:

Capítulo 8 – Autómatas orgánicos

Independientemente de su origen estos protobiontes requirieron una serie de condiciones que garanticen su existencia, estas son: una barrera entre el medio exterior y lo propio, un adecuado aprovechamiento de la luz, que se logró por medio de porfirinas, y un medio estable de nutrientes y de condiciones físicas.

A medida que el protobionte va acumulando una serie de polímeros adquiere nuevas capacidades: dividirse y tener un metabolismo basal. Esta última propiedad solo podría ser heredada a uno de los protobiontes hijos, ya que carecían de una maquinaria genética. Cualquier innovación le otorgaría un gran aumento de potencial evolutivo como lo fue en su momento el paso a la vida heterótrofa.

Nuevamente nos enfrentamos al problema de la concentración, problema que es resuelto por el acoplamiento de una molécula energética básica, el pirofosfato; este logra vencer las barreras de la baja concentración y activa las moléculas para que reaccionen entre sí.

Por ejemplo, la siguiente reacción muestra la activación de la glicina por parte del pirofosfato

Capítulo 9 – Genética

Los polinucleótidos formaron el aparato genético básico, estos tienen la característica de duplicarse de forma exacta emparejando sus bases nitrogenadas con los nucleótidos libres del medio. Esta molécula, ADN, podría agruparse con otra que posea la misma secuencia y enrollarse entre sí, esto aumentaría la estabilidad del polímero.

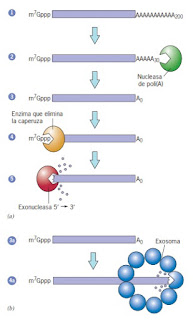

Existen una serie de proteínas que facilitan la replicación y garantizan la integridad del polinucleótido. A continuación se presenta la maquinaria molecular de dicho proceso en una célula.

La secuencia básica fue el ADN ya partir de ella se forma el ARN, este consiste en una cadena de poliribonuecleótidos.

El ARN puede cumplir las siguientes funciones: autoenrrollarse y con la ayuda de una serie de proteínas formar un orgánulo llamado ribosoma que favorece la unión del ARN mensajero y el ARN transferencia, este subtipo se conoce como ARN ribosomal.

El ADN de transferencia cumple la función de vincular un aminoácido con una secuencia específica encontrada en el ARN mensajero, por medio de sitios de unión específicos y con la ayuda de proteínas. Específicamente, el ARN de transferencia se una con el aminoácido mediante la secuencia CCA. En el ARN mensajero existen unas secuencias especiales que no cumplen con una función especifica de transmisión de mensaje sino de iniciar la traducción y detenerla; en el primer caso la secuencia codifica el aminoácido metionina en eucariotas y formilmetionina en procariotas. Las secuencias de pare no codifican algún aminoácido sino cumplen la función de desestabilizar el complejo Ribosoma-ARN y terminar la traducción.

El código genético parece ser universal: un triplete que codifica un aminoácido, la secuencia de este triplete es la misma en todas las formas de vida; el motivo de esto se desconoce, pero si encontrásemos una muestra de vida extraterrestre el problema sería resuelto.

A continuación se presenta la relación entre los codones y aminoácidos, esta traducción es universal.

Capítulo 10 – Origen de la protocélula genética

Todas las protocélula tiene un problema en común; aunque por casualidad una protocélula contuviera una proteína útil, no habría modo posible de asegurar que habría ocurrido con esa proteína para que pasara a las protocélulas hijas. No existía una reproducción en exceso de los puntos heredables específicos que podrían estar sujetos a la selección natural.

El éxito de una gran biomolécula está relacionado con el control, estabilización, la obtención de un lugar específico en la célula: un nicho molecular.

Para empezar, debemos hacer dos suposiciones: la existencia de un pequeño prototipo de ARN molde llamado ARN generador que funciona tanto como molde que como almacén de información y la existencia de un proto-ARN de transferencia.

Para comprender el acoplamiento de los aminoácidos a los proto-ARN de transferencia se propone la existencia de un tramo pequeño de la secuencia de bases proximal al extremo abierto actuaba como discriminador. Una cierta secuencia de bases discriminadora podría seleccionar una clase de aminoácidos por carga, pH, fuerzas electrostáticas, etc.

La regla de un nivel trófico común (todos los organismos utilizan de las mismas unidades básicas) no condiciona compartir el mismo sistema de lectura. La universalidad es la clave genética para la simbiosis entre los cloroplastos, mitocondrias y las células eucariotas porque esta les otorga el ARNt a los simbiontes. Aunque se traten de hacer suposiciones sobre el motivo de la universalidad del código genético aún no tenemos las suficientes pruebas para encontrar una respuesta.

Capítulo 11 – Evolución de las protocélulas genéticas

Los generadores circulares, de 12 bases, puede ser replicados continuamente dando lugar a moléculas mucho mayores que también puede circularizarse. Para que suceda esto hemos de asumir la presencia de algunos péptidos que catalicen la formación de oligonucleótidos. Este proceso crea dos grupos de moléculas nuevas y más grandes: las circulares y las líneas permutadas.

Los generadores grandes han de contener la secuencia del generador primitivo muchas veces duplicada y algunas de estas dúplicas tendrán errores de replicación ya que el proceso de replicación es inexacto.

Las presiones de selección en favor de células que pudieran modificar un compuesto obtenible aquí debieron ser muy grandes; por ello, si una protocélula tenía una mutación en su generador que la hacía más apta esta aumentaría su frecuencia en gran medida.

El nivel trófico común solo exige un conjunto común de moléculas pequeñas, no parece necesitar la universalidad de las rutas metabólicas y pese a ello esto es una realidad. Esto nos dirige a pensar que: toda la vida procede de una sola raza de población o que toda ruta metabólica de nuestra bioquímica actual utiliza para la optimización evolutiva aquellas moléculas que son únicamente estables, este último planteamiento es el más aceptado.

A varios metros de profundidad, en los pantanos, la mayor parte de la radiación UV es absorbida por la propia agua, esto no ocurre con la luz visible. Este fenómeno natural produce una selección intensa para la utilización de la luz visible del sol, para lo que hace falta clorofila y un sistema enzimático de transporte de electrones.

A medida que aparecen células fotosintéticas que usan la luz visible se libera O2, cuando las concentraciones en el mar llegan a un punto el O2 logra difundirse a la atmosfera. Cuando las concentraciones de O2 llegan al 3% resulta posible el aprovecharlo como receptores de electrones altamente eficiente en un metabolismo aerobio.

Estos y muchos otros acontecimientos podrían haber ocurrido una vez que apareciera un aparato genético y un sistema de síntesis de proteínas para dar lugar a poblaciones celulares sobre las cuales pudo actuar la selección natural.

Capítulo 12 – Conjeturas

Los sistemas biológicos requieren enantiómeros específicos: solo se usan los aminoácidos de la serie L, del RNA solo D ribosa, etc. Las propiedades físicas de algunos enantiómeros son muy distintas, por ejemplo: la solubilidad, los puntos de fusión, etc. Las moléculas quirales usadas fueron seleccionadas durante la evolución primaria por sus propiedades un poco más ventajosa en esa época.

Estas selecciones representan unos minutos cruciales de la evolución que, una vez pasados, se fueron para siempre por lo que actualmente esta selección no tiene sentido aparente.

Capítulo 13 – Realidades

Los compuestos muy reactivos, como son los azúcares, nunca aparecen en los experimentos generales de la evolución química. En el mundo abierto y amplio de los pequeños pantanos cálidos, los azúcares debieron tener muchos rincones en los que esconderse de las sustancias con las podrían reaccionar, rincones que no existen en un experimento de evolución química.

Quizá lleguemos a ser una especie de ingeniosos monos que ha diseñado computadoras aún más ingeniosas para realizar el trabajo real del universo; y aunque suceda todo esto, habremos de dejar a nuestras computadoras un legado muy humano, quizás el más humano de todos: la curiosidad.